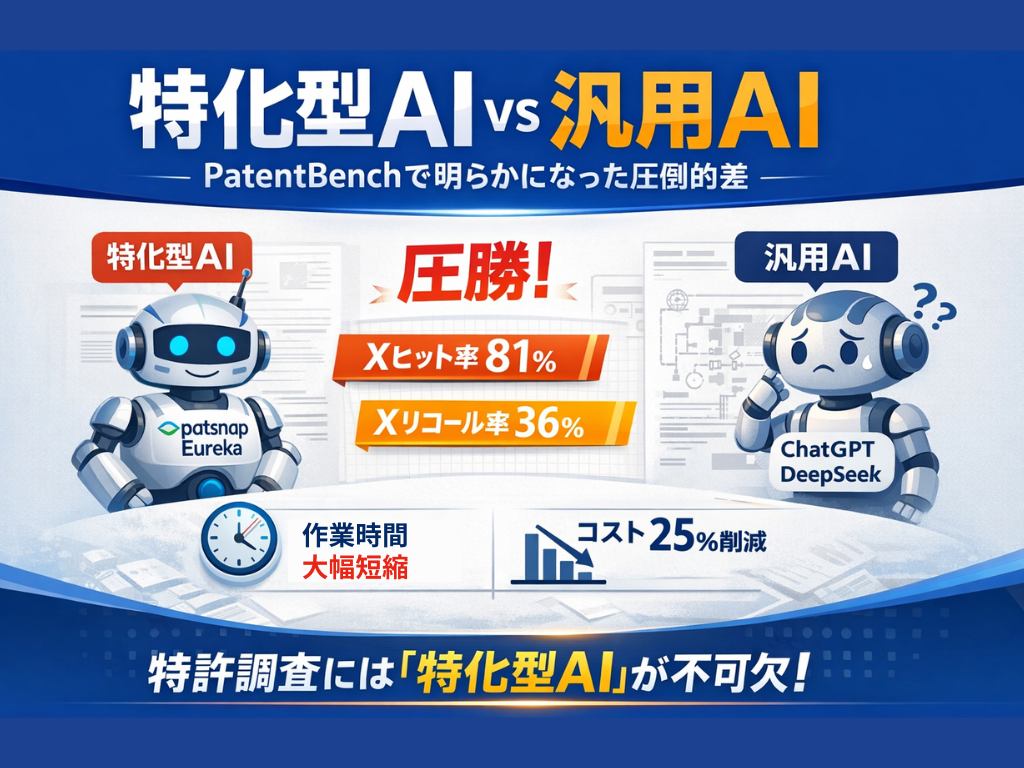

【検証】「PatentBench」が示す特化型AIの圧倒的実力

「ChatGPTやDeepSeekなどの汎用AIは、特許調査のような専門業務にどこまで通用するのか?」

多くの知財担当者やR&Dリーダーが抱くこの疑問に対し、Patsnapは客観的な答えを出すために新たなベンチマークテスト「PatentBench」を実施しました。

今回は、最新の汎用LLM(大規模言語モデル)と、Patsnapの特化型AIエージェントを徹底比較した衝撃的な結果と、それが実務にもたらす変革についてご紹介します。

出所:https://www.patsnap.com/benchmark

1. PatentBenchとは?:AIの「知財実務能力」を測る世界基準

「PatentBench」は、単にAIがそれらしい文章を書けるかを評価するものではありません。実際の特許業務(今回は「新規性調査」)において、審査官が引用した先行技術(X文献)をAIがどれだけ正確に見つけ出せるかを定量的に評価するベンチマークです。

評価の公平性を担保する設計

-

テスト対象:

-

Patsnap Eureka(新規性調査エージェント)

-

ChatGPT-o3(ウェブ検索対応)

-

DeepSeek-R1(ウェブ検索対応)

-

-

サンプル数: 340件(日米欧中の特許庁データを含むバランスの取れた構成)

-

正解データ: 実際の審査で引用されたX文献(先行技術)を「標準解答」として設定

2. 結果発表:特化型AI vs 汎用AIの精度比較

検証の結果、Patsnap Eureka(特化型AI)は、汎用LLMに対して圧倒的なパフォーマンス差を見せつけました。特許調査において最も重要視される2つの指標をご覧ください。

【Top100検索結果における成績】

① Xヒット率(X Hit Rate):81%

-

意味: 対象案件に対し、少なくとも1件以上の重要な先行技術(X文献)を見つけられた割合。

-

結果: Patsnap Eurekaは、約5分の4の案件で決定的な文献を検出しました。これは初期スクリーニングや方向性の決定において極めて高い信頼性を意味します。

② Xリコール率(X Recall Rate):36%

-

意味: 正解となるX文献の総数のうち、何割を網羅できたか。

-

結果: 汎用AIが苦戦する中、Patsnap Eurekaは36%の検出に成功。見落としのリスクを減らし、権利化率の向上に貢献します。

実際のテスト例 あるサンプル案件では、Patsnap Eurekaが正解文献を 3件検出(ヒット率100%) したのに対し、汎用AIは見つけることができず、実務利用にはまだ大きな壁があることが浮き彫りになりました。

3. なぜこれほどの差が出るのか?「垂直領域モデル」×「RAG技術」

勝敗を分けたのは、「垂直領域モデル」×「RAG技術」の組み合わせです。

汎用AIはあらゆる情報を学習していますが、特許特有の難解な言語や検索ロジックの理解には限界があります。一方、Patsnap Eurekaは以下の強みを持っています。

-

20億件以上の構造化データ 特許、科学論文、訴訟データなど、膨大な知財データを学習済みです。

-

専門知識による調整 オープンソースの大規模モデルを、特許分野の専門知識で体系的にファインチューニングしています。

-

RAG(検索強化生成) AIの生成能力とリアルタイム検索能力を統合し、ハルシネーション(もっともらしい嘘)を抑制して高精度な回答を導き出します。

4. 導入効果:「3日間の作業」が「3時間」に変わる

この技術革新は、皆様の業務にどのようなインパクトを与えるでしょうか? 従来、数時間〜数日かかっていた検索・抽出・並び替え作業が、Patsnap Eurekaを使えばわずか数分で完了します。

-

イノベーション速度: 75%向上

-

コスト: 25%削減

-

業務変革: 「3日間の反復的な検索作業」から解放され、「3時間の高品質な分析・意思決定」へ時間をシフトできます。

R&Dの初期段階で活用すれば、新規性不足のリスクを早期に発見し、開発リソースの無駄を最小限に抑えることも可能です。

5. 結論:AI活用は「汎用」から「特化型」の時代へ

PatentBenchの結果は、特許調査のような高度な専門性が求められる領域において、汎用AIには限界があり、特化型AIエージェントが不可欠であることを証明しました。

-

「AIを導入したいが、精度が不安」

-

「調査業務の効率化が急務」

そうお考えの知財プロフェッショナル、R&Dチームの皆様。 世界15,000社以上のイノベーターに信頼されるPatsnapの実力を、ぜひご自身の目で確かめてください。

▼ 【無料デモ・資料請求】Patsnap Eurekaの詳細はこちら